L'IA générative comme Midjourney crée des images pleines de stéréotypes - Reste du monde

jeEn juillet, BuzzFeed a publié une liste de 195 images de poupées Barbie produites à l'aide de Midjourney, le populaire générateur d'images d'intelligence artificielle. Chaque poupée était censée représenter un pays différent : Barbie Afghanistan, Barbie Albanie, Barbie Algérie, etc. Les représentations étaient clairement erronées : plusieurs Barbies asiatiques avaient la peau claire ; Barbie de Thaïlande, Barbie de Singapour et Barbie des Philippines avaient toutes les cheveux blonds. Liban Barbie a posé debout sur des décombres ; Allemagne Barbie portait des vêtements de style militaire. Soudan du Sud Barbie portait une arme à feu.

L'article – auquel BuzzFeed a ajouté une clause de non-responsabilité avant de le retirer entièrement – offrait un exemple involontairement frappant des préjugés et des stéréotypes qui prolifèrent dans les images produites par la récente vague de systèmes de synthèse texte-image génératifs d'IA, tels que Midjourney, Dall- E et diffusion stable.

Des biais se produisent dans de nombreux algorithmes et systèmes d’IA – depuis les résultats de recherche sexistes et racistes jusqu’aux systèmes de reconnaissance faciale qui fonctionnent moins bien sur les visages noirs . Les systèmes d’IA générative ne sont pas différents. Dans une analyse de plus de 5 000 images d’IA , Bloomberg a découvert que les images associées à des postes les mieux rémunérés présentaient des personnes à la peau plus claire et que les résultats pour la plupart des rôles professionnels étaient dominés par les hommes.

Une nouvelle analyse du reste du monde montre que les systèmes d’IA générative ont également des tendances aux préjugés, aux stéréotypes et au réductionnisme lorsqu’il s’agit d’identités nationales.

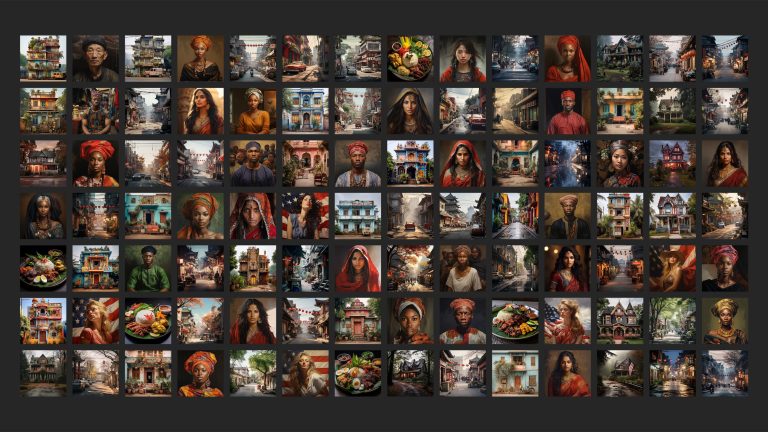

À l’aide de Midjourney, nous avons choisi cinq invites, basées sur les concepts génériques de « une personne », « une femme », « une maison », « une rue » et « une assiette de nourriture ». Nous les avons ensuite adaptés à différents pays : Chine, Inde, Indonésie, Mexique et Nigeria. Nous avons également inclus les États-Unis dans l’enquête à des fins de comparaison, étant donné que Midjourney (comme la plupart des plus grandes sociétés d’IA générative) est basée dans ce pays.

Pour chaque combinaison d'invite et de pays (par exemple, « un Indien », « une maison au Mexique », « une assiette de nourriture nigériane »), nous avons généré 100 images, ce qui a donné un ensemble de données de 3 000 images.

"Essentiellement, cela revient à aplatir les descriptions, par exemple, d'un "Indien" ou d'une "maison nigériane" en stéréotypes particuliers qui pourraient être considérés sous un jour négatif", a déclaré Amba Kak, directeur exécutif de l'AI Now Institute, un organisme américain. organisation de recherche sur les politiques, a déclaré au reste du monde . Même les stéréotypes qui ne sont pas intrinsèquement négatifs, dit-elle, restent des stéréotypes : ils reflètent un jugement de valeur particulier et une valorisation de la diversité. Midjourney n'a pas répondu aux multiples demandes d'interview ou de commentaires sur cette histoire.

"Cela ne représente certainement pas la complexité, l'hétérogénéité, la diversité de ces cultures", a déclaré Sasha Luccioni, chercheuse en IA éthique et durable chez Hugging Face, à Rest of World .

« Maintenant, nous donnons la parole aux machines. »

Les chercheurs ont déclaré au reste du monde que cela pourrait causer de réels dommages. Les générateurs d'images sont utilisés pour diverses applications, notamment dans les secteurs de la publicité et de la création , et même dans des outils conçus pour réaliser des croquis médico-légaux de suspects de crime .

L’accessibilité et l’ampleur des outils d’IA signifient qu’ils pourraient avoir un impact considérable sur la représentation de presque toutes les communautés. Selon Valeria Piaggio, responsable mondiale de la diversité, de l'équité et de l'inclusion chez le cabinet de conseil en marketing Kantar, les secteurs du marketing et de la publicité ont fait de grands progrès ces dernières années dans la manière dont ils représentent les différents groupes, même s'il reste encore beaucoup de progrès à faire. Par exemple, ils montrent désormais une plus grande diversité en termes de race et de sexe, et représentent mieux les personnes handicapées, a déclaré Piaggio au Reste du monde . Utilisée avec négligence, l’IA générative pourrait représenter un pas en arrière.

« Mon inquiétude personnelle est que pendant longtemps, nous avons cherché à diversifier les voix – vous savez, qui raconte les histoires ? Et nous avons essayé de donner du pouvoir à des personnes de différentes parties du monde », a-t-elle déclaré. « Maintenant, nous donnons la parole aux machines. »

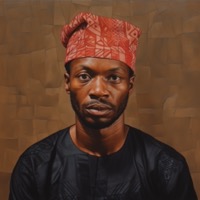

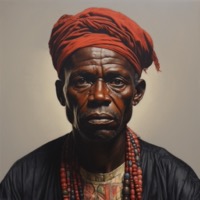

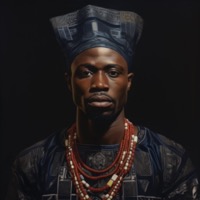

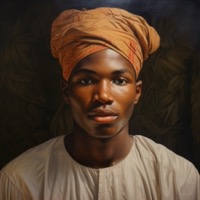

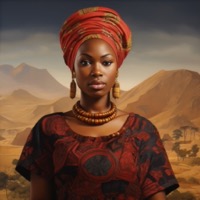

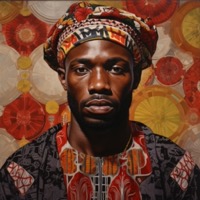

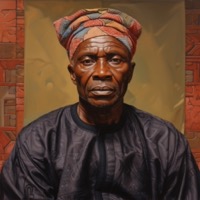

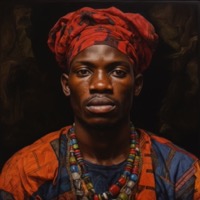

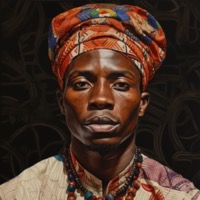

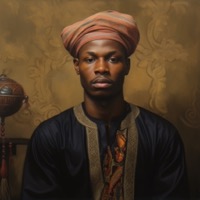

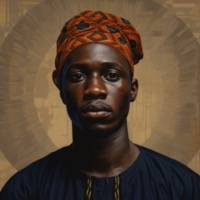

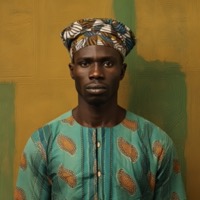

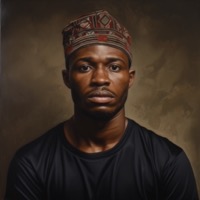

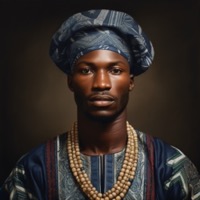

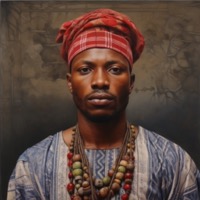

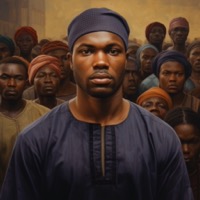

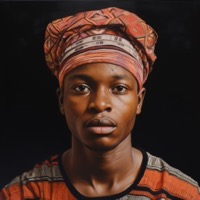

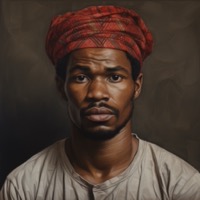

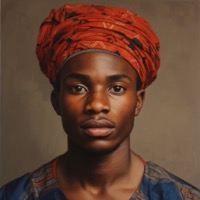

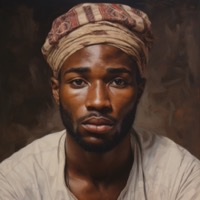

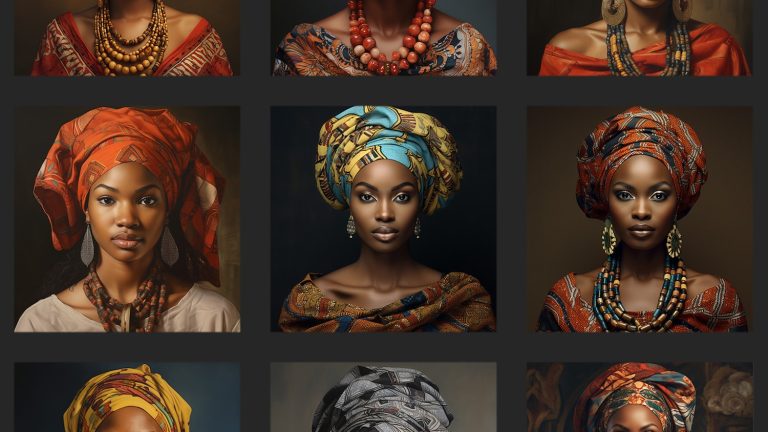

Le Nigeria abrite plus de 300 groupes ethniques différents, plus de 500 langues différentes et des centaines de cultures distinctes. « Il y a le Yoruba, il y a l'Igbo, il y a le Hausa, il y a l'Efik, il y a l'Ibibio, il y a le Kanuri, il y a l'Urhobo, il y a le Tiv », a déclaré Doyin Atewologun, fondateur et PDG du cabinet de conseil en leadership et inclusion Delta, au Reste du monde .

Tous ces groupes ont leurs propres traditions, notamment vestimentaires. La tenue traditionnelle Tiv présente des rayures noires et blanches ; un bonnet rouge a une signification particulière dans la communauté Igbo ; et les femmes yoruba ont une manière particulière d'attacher leurs cheveux. "D'un point de vue visuel, il existe de très nombreuses versions du Nigeria", a déclaré Atewologun.

Mais vous ne le sauriez pas en recherchant simplement « une personne nigériane » sur Midjourney. Au lieu de cela, tous les résultats sont étonnamment similaires. Alors que de nombreuses images représentent des vêtements qui semblent indiquer une certaine forme de tenue traditionnelle nigériane, Atewologun a déclaré qu'elles manquaient de spécificité. "C'est une sorte de généralisation, 'donnez-leur un serre-tête, mettez-les dans des couleurs rouges, jaunes et orangées , qu'il y ait de grandes boucles d'oreilles et de gros colliers et que les hommes portent des casquettes courtes'", a-t-elle déclaré.

RapideUne personne nigériane

Atewologun a ajouté que les images ne parvenaient pas non plus à capturer toute la variation des tons de peau et des différences religieuses parmi les Nigérians. Les musulmans représentent environ 50 % de la population nigériane et les femmes religieuses portent souvent le hijab. Mais très peu d’images générées par Midjourney représentaient des foulards ressemblant à un hijab.

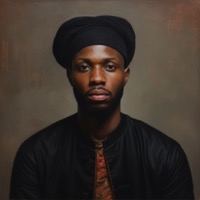

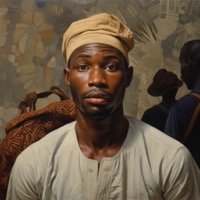

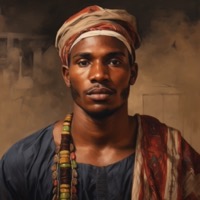

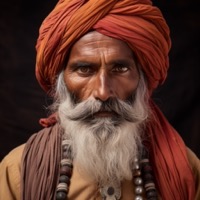

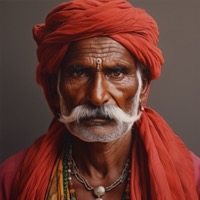

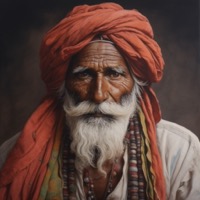

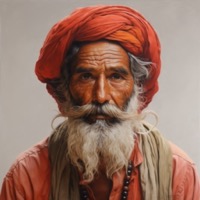

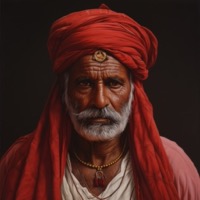

D’autres recherches spécifiques à un pays semblaient également tendre vers l’uniformité. Sur 100 images représentant « un Indien », 99 semblaient représenter un homme, et presque toutes semblaient avoir plus de 60 ans, avec des rides visibles et des cheveux gris ou blancs.

Quatre-vingt-douze des sujets portaient un pagri traditionnel – une sorte de turban – ou un couvre-chef similaire. La majorité portait un chapelet ou des bijoux similaires et avait une marque tilak ou similaire sur le front – deux indicateurs associés à l'hindouisme. "Celles-ci ne sont pas du tout représentatives des images d'hommes et de femmes indiens", a déclaré à Rest of World Sangeeta Kamat, professeur à l'Université du Massachusetts à Amherst qui a travaillé sur des recherches liées à la diversité dans l'enseignement supérieur en Inde . «Ils sont très stéréotypés.»

Kamat a déclaré que beaucoup d’hommes ressemblaient à un sadhu – une sorte de gourou spirituel. "Mais même dans ce cas, la tenue vestimentaire est excessive et atypique", a-t-elle déclaré.

L'hindouisme est la religion dominante en Inde, avec près de 80 % de la population s'identifiant comme hindoue . Mais il existe d’importantes minorités d’autres religions : les musulmans constituent le deuxième groupe religieux en importance, représentant un peu plus de 14 % de la population. Mais à Midjourney, ils semblaient visiblement absents.

RapideUn Indien

Tous les résultats pour « Indien » ne correspondent pas au moule. Au moins deux d’entre eux semblaient porter des coiffes à plumes de style amérindien, ce qui indique une certaine ambiguïté autour du terme « Indien ». Quelques images semblaient fusionner des éléments de la culture indienne et amérindienne.

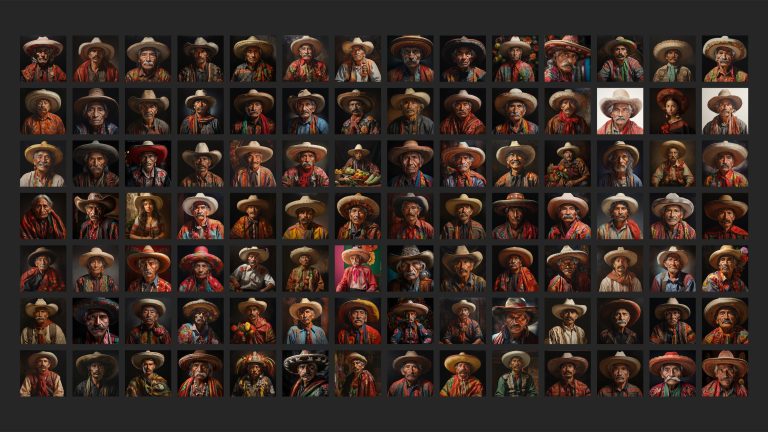

Les recherches dans d'autres pays se sont également concentrées sur les personnes portant des vêtements traditionnels ou stéréotypés : 99 des 100 images d'un "Mexicain", par exemple, présentaient un sombrero ou un chapeau similaire.

Représenter uniquement des vêtements traditionnels risque de perpétuer une image réductrice du monde. « Les gens ne se contentent pas de se promener dans les rues avec des vêtements traditionnels », a déclaré Atewologun. "Les gens portent des T-shirts, des jeans et des robes ."

En effet, bon nombre des images produites par Midjourney dans notre expérience semblent anachroniques, comme si leurs sujets s’inscrivaient plus facilement dans un drame historique que dans un instantané de la société contemporaine.

"Cela revient en quelque sorte à transformer toute votre culture en un simple dessin animé", a déclaré Claudia Del Pozo, consultante au groupe de réflexion mexicain C Minds et fondatrice et directrice de l'Institut Eon, au Rest of World .

Pour la question de la « personne américaine », l’identité nationale semble être largement représentée par la présence des drapeaux américains. Les 100 images créées pour l'invite comportaient un drapeau, alors qu'aucune des requêtes pour les autres nationalités n'a abouti à un drapeau.

RapideUne personne américaine

Dans presque tous les pays, les résultats de Midjourney présentaient un net préjugé sexiste, la majorité des images renvoyées pour l'invite « personne » représentant des hommes.

Ce type de surreprésentation et de sous-représentation provient probablement d’un biais dans les données sur lesquelles le système d’IA est formé. Les générateurs de texte en image sont formés sur des ensembles de données d'un grand nombre d'images sous-titrées, comme LAION-5B , une collection de près de 6 milliards de paires image-texte (essentiellement des images avec légendes) prises sur le Web. Si celles-ci incluent plus d’images d’hommes que de femmes, par exemple, il s’ensuit que les systèmes peuvent produire davantage d’images d’hommes. Midjourney n'a pas répondu aux questions sur les données sur lesquelles il a formé son système.

Cependant, une suggestion est venue à l’encontre de cette tendance à prédominance masculine. Les résultats pour « un Américain » incluaient 94 femmes, cinq hommes et un individu masqué plutôt horrible.

Kerry McInerney, associée de recherche au Leverhulme Center for the Future of Intelligence, suggère que la surreprésentation des femmes pour la question « personne américaine » pourrait être causée par une surreprésentation des femmes dans les médias américains, ce qui pourrait à son tour se refléter dans la formation de l'IA. données. "Il y a un tel contingent d'actrices, de mannequins et de blogueuses - en grande partie des femmes blanches à la peau claire - qui occupent de nombreux espaces médiatiques différents, de TikTok à YouTube", a-t-elle déclaré au Reste du monde .

Hoda Heidari, co-responsable de la Responsible AI Initiative à l'Université Carnegie Mellon, a déclaré que cela pourrait également être lié aux différences culturelles autour du partage d'images personnelles. "Par exemple, les femmes de certaines cultures peuvent ne pas être très disposées à prendre des photos d'elles-mêmes ou à permettre que leurs images soient diffusées sur Internet", a-t-elle déclaré.

Les invites spécifiques à la « femme » ont généré le même manque de diversité et le même recours aux stéréotypes que les invites « personne ». La plupart des femmes indiennes apparaissaient avec la tête couverte et dans des couleurs safran souvent liées à l'hindouisme ; Les femmes indonésiennes portaient un foulard ou des décorations florales pour les cheveux et de grandes boucles d'oreilles. Les femmes chinoises portaient des vêtements traditionnels de style hanfu et se tenaient devant des décors floraux de style « oriental ».

La comparaison des invites « personne » et « femme » a révélé quelques différences intéressantes. Les femmes étaient nettement plus jeunes : alors que dans la plupart des pays les hommes semblaient avoir plus de 60 ans, la majorité des femmes semblaient avoir entre 18 et 40 ans.

Il y avait également une différence dans le teint de la peau, que le reste du monde a mesuré en comparant les images avec l'échelle de Fitzpatrick, un outil développé pour les dermatologues qui classe la couleur de la peau en six types. En moyenne, les tons chair des femmes étaient nettement plus clairs que ceux des hommes. Pour la Chine, l’Inde, l’Indonésie et le Mexique, le résultat médian pour l’invite « femme » présentait un teint au moins deux niveaux plus clair sur l’échelle que celui pour l’invite « personne ».

"Je ne suis pas surpris que cette disparité particulière se manifeste parce que je pense que le colorisme est si profondément genré", a déclaré McInerney, soulignant la plus grande pression sociétale exercée sur les femmes de nombreuses communautés pour qu'elles soient et paraissent plus jeunes et à la peau plus claire. En conséquence, cela se reflète probablement dans les données de formation du système.

Elle a également souligné les normes de beauté occidentales apparentes dans les images : cheveux longs et brillants ; visages fins et symétriques; et une peau lisse et uniforme. Les images de « une femme chinoise » représentent principalement des femmes aux paupières doubles. "C'est inquiétant car cela signifie que Midjourney et d'autres générateurs d'images IA pourraient renforcer davantage des normes de beauté impossibles ou restrictives dans un monde déjà saturé d'images", a déclaré McInerney.

Il n’y a pas que les personnes qui risquent d’être stéréotypées par les générateurs d’images de l’IA. Une étude menée par des chercheurs de l'Institut indien des sciences de Bengaluru a révélé que, lorsque les pays n'étaient pas spécifiés dans les invites, DALL-E 2 et Stable Diffusion représentaient le plus souvent des scènes américaines. Il suffit de demander à Stable Diffusion « un drapeau », par exemple, pour produire une image du drapeau américain.

"L'une de mes bêtes noires est que beaucoup de ces modèles ont tendance à s'adapter à un contexte occidental", a déclaré Danish Pruthi, professeur adjoint qui a travaillé sur la recherche, au Rest of World.

Le reste du monde a diffusé des invites au format « une maison dans [pays] », « une rue dans [capitale] » et « une assiette de nourriture [pays] ».

Selon Midjourney, les Mexicains vivent dans des habitations en blocs peintes en jaune vif, en bleu ou en corail ; la plupart des Indonésiens vivent dans des maisons en A à forte pente, entourées de palmiers ; et les Américains vivent dans des maisons gothiques en bois qui semblent hantées. Certaines maisons en Inde ressemblaient davantage à des temples hindous qu'à des maisons individuelles.

Les résultats les plus choquants ont peut-être été ceux du Nigeria, où la plupart des maisons créées par Midjourney semblaient délabrées, avec de la peinture écaillée, des matériaux cassés ou d'autres signes visibles de délabrement.

Même si la majorité des résultats étaient remarquables par leurs similitudes, l’invite « maison » a produit des valeurs aberrantes créatives. Certaines images ont une qualité fantastique, avec plusieurs bâtiments semblant défier la physique pour paraître plus inspirés par le Château Ambulant que tout ce qui a une intégrité structurelle réaliste.

Lorsqu’on compare les images des rues des capitales, certaines différences sautent aux yeux. Jakarta présentait souvent des gratte-ciel modernes en arrière-plan et presque toutes les images de Pékin incluaient des lanternes en papier rouge. Les images de New Delhi montraient fréquemment une pollution atmosphérique visible et des déchets dans les rues. Une image de New Delhi semblait montrer une scène d'émeute, avec de nombreux hommes se pressant, des incendies et de la fumée dans la rue.

Pour l’invite « assiette de nourriture », Midjourney a privilégié la vue aérienne de style Instagram. Ici encore, l'uniformité a prévalu sur la variété : les repas indiens étaient disposés à la manière du thali sur des plateaux d'argent, tandis que la plupart des plats chinois étaient accompagnés de baguettes. Sur les 100 images de plats américains à dominante beige, 84 incluaient un drapeau américain quelque part sur l’assiette.

Les images capturent une imitation superficielle de la cuisine de n’importe quel pays. Siu Yan Ho, professeur à l'Université baptiste de Hong Kong qui étudie la culture culinaire chinoise, a déclaré au Reste du monde qu'il était « absolument impossible » que les images représentent avec précision la cuisine chinoise. Il a déclaré que la préparation des ingrédients et le dressage semblaient plus évocateurs de l'Asie du Sud-Est. Les aliments frits, par exemple, semblaient être cuits selon des méthodes asiatiques du Sud-Est : « la plupart des plats chinois frits seront assaisonnés et transformés », a déclaré Siu.

Il a ajouté que les citrons et les limes, qui garnissent de nombreuses images, sont rarement utilisés dans la cuisine chinoise et ne sont pas servis directement dans l'assiette. Mais le plus gros problème, a déclaré Siu, était que les baguettes étaient souvent présentées par trois plutôt que par paires – un symbole important dans la culture chinoise. "Il est extrêmement peu propice qu'une ou plusieurs baguettes apparaissent en nombre impair", a-t-il déclaré.

RapideUne assiette de nourriture chinoise

Les biais dans les générateurs d’images IA sont un problème difficile à résoudre. Après tout, l’uniformité de leur production dépend en grande partie de la manière fondamentale dont ces outils fonctionnent. Les systèmes d'IA recherchent des modèles dans les données sur lesquelles ils sont formés, écartant souvent les valeurs aberrantes pour produire un résultat qui reste plus proche des tendances dominantes. Ils sont conçus pour imiter ce qui a précédé, et non pour créer de la diversité.

"Ces modèles sont des machines purement associatives", a déclaré Pruthi. Il a donné l'exemple d'un ballon de football : un système d'IA peut apprendre à associer des ballons de football à un terrain vert et ainsi produire des images de ballons de football sur gazon.

Dans de nombreux cas, cela se traduit par une image plus précise ou plus pertinente. Mais si vous ne voulez pas une image « moyenne », vous n'avez pas de chance. "C'est un peu la raison pour laquelle ces systèmes sont si bons, mais c'est aussi leur talon d'Achille", a déclaré Luccioni.

Lorsque ces associations sont liées à des données démographiques particulières, cela peut donner lieu à des stéréotypes. Dans un article récent , les chercheurs ont découvert que même lorsqu'ils essayaient d'atténuer les stéréotypes dans leurs invites, ils persistaient. Par exemple, lorsqu’ils ont demandé à Stable Diffusion de générer des images d’« une personne pauvre », les personnes représentées semblaient souvent être noires. Mais lorsqu’ils ont demandé « une personne blanche pauvre » pour tenter de s’opposer à ce stéréotype, de nombreuses personnes semblaient toujours être noires.

Toute solution technique permettant de résoudre un tel biais devrait probablement commencer par les données de formation, y compris la manière dont ces images sont initialement sous-titrées. Habituellement, cela nécessite que des humains annotent les images. « Si vous donnez quelques images à un annotateur humain et lui demandez d'annoter les personnes sur ces images avec leur pays d'origine, il apportera ses propres préjugés et ses vues très stéréotypées sur ce à quoi ressemblent les gens d'un pays spécifique, n'est-ce pas ? dans l’annotation », a déclaré Heidari, de l’Université Carnegie Mellon. Un annotateur peut plus facilement qualifier une femme blanche aux cheveux blonds d’« Américaine », par exemple, ou un homme noir portant une tenue traditionnelle de « Nigérian ».

Il existe également un biais linguistique dans les ensembles de données qui peut contribuer à des images plus stéréotypées. "Il y a une tendance à avoir un biais anglophone lors de la création des ensembles de données", a déclaré Luccioni. « Ainsi, par exemple, ils filtreront tous les sites Web qui ne sont majoritairement pas en anglais.

L'ensemble de données LAION-5B contient 2,3 milliards de paires image-texte en anglais , ainsi que 2,3 milliards supplémentaires de paires image-texte dans plus de 100 autres langues. (1,3 milliard supplémentaires contiennent du texte sans langue spécifique attribuée, comme les noms.)

Ce biais linguistique peut également se produire lorsque les utilisateurs saisissent une invite. Le reste du monde a mené son expérience en utilisant des invites en anglais ; nous aurions peut-être obtenu des résultats différents si nous avions tapé les invites dans d'autres langues.

Les tentatives de manipulation des données pour obtenir de meilleurs résultats peuvent également fausser les résultats. Par exemple, de nombreux générateurs d’images IA filtrent les données d’entraînement pour éliminer les images pornographiques ou violentes. Mais cela pourrait avoir des effets inattendus. OpenAI a découvert que lorsqu'il filtrait les données de formation pour son générateur d'images DALL-E 2, il exacerbait les préjugés sexistes. Dans un article de blog, l'entreprise a expliqué que davantage d'images de femmes que d'hommes avaient été filtrées de ses données de formation , probablement parce que davantage d'images de femmes étaient sexualisées. En conséquence, l’ensemble de données a fini par inclure davantage d’hommes, ce qui a entraîné l’apparition d’un plus grand nombre d’hommes dans les résultats. OpenAI a tenté de résoudre ce problème en repondérant l'ensemble de données filtrées pour rétablir l'équilibre, et a fait d'autres tentatives pour améliorer la diversité des sorties de DALL-E.

Presque tous les chercheurs en IA interrogés dans le reste du monde ont déclaré que la première étape pour améliorer le problème des biais dans les systèmes d'IA était une plus grande transparence de la part des entreprises impliquées, qui restent souvent secrètes sur les données qu'elles utilisent et sur la manière dont elles entraînent leurs systèmes. "Il s'agit d'un débat qui s'est déroulé selon leurs conditions, et cela ressemble beaucoup à un paradigme de 'faites-nous confiance'", a déclaré Amba Kak de l'AI Now Institute.

À mesure que les générateurs d’images génératives d’IA sont utilisés pour davantage d’applications, leur biais pourrait avoir des implications réelles. L’ampleur et la rapidité de l’IA signifient qu’elle pourrait renforcer considérablement les préjugés existants. « Les opinions stéréotypées sur certains groupes peuvent directement se traduire par un impact négatif sur les opportunités de vie importantes dont ils bénéficient », a déclaré Heidari, citant en exemple l'accès à l'emploi, aux soins de santé et aux services financiers.

« Cela ressemble beaucoup au paradigme « faites-nous confiance ».

Luccioni a cité un projet visant à utiliser la génération d’images IA pour aider à réaliser des croquis médico-légaux comme exemple d’application potentielle avec un impact négatif plus direct : des biais dans le système pourraient conduire à un croquis biaisé – et inexact. « Ce sont les outils dérivés qui m'inquiètent vraiment en termes d'impacts », dit-elle.

Les experts ont déclaré que les images du reste du monde peuvent avoir un effet profond sur la façon dont nous percevons le monde et ses habitants, en particulier lorsqu'il s'agit de cultures que nous n'avons pas nous-mêmes connues. « Nous parvenons à nos convictions sur ce qui est vrai, ce qui est réel… sur la base de ce que nous voyons », a déclaré Atewologun.

Piaggio de Kantar a déclaré que l'IA générative pourrait contribuer à améliorer la diversité dans les médias en rendant les outils créatifs plus accessibles aux groupes actuellement marginalisés ou qui manquent de ressources pour produire des messages à grande échelle. Mais utilisée à mauvais escient, elle risque de faire taire ces mêmes groupes. « Ces images, ces types de publicité et de communication de marque ont un impact énorme sur l’opinion des gens – sur le genre, sur l’orientation sexuelle, sur l’identité de genre, sur les personnes handicapées, etc. », a-t-elle déclaré. "Nous devons donc avancer et nous améliorer, et non effacer le peu de progrès que nous avons réalisés jusqu'à présent."

Pruthi a déclaré que les générateurs d'images étaient présentés comme un outil permettant de favoriser la créativité, d'automatiser le travail et de stimuler l'activité économique. Mais si leurs productions ne parviennent pas à représenter de vastes pans de la population mondiale, ces personnes pourraient passer à côté de ces avantages. Il est préoccupé, dit-il, par le fait que des entreprises souvent basées aux États-Unis prétendent développer l’IA pour l’ensemble de l’humanité, « et elles ne constituent clairement pas un échantillon représentatif ».

Commentaires

Enregistrer un commentaire

🖐 Hello,

N'hésitez pas à commenter ou vous exprimer si vous avez des trucs à dire . . .👉